代码大模型微调_代码大模型微调

*** 次数:1999998 已用完,请联系开发者***

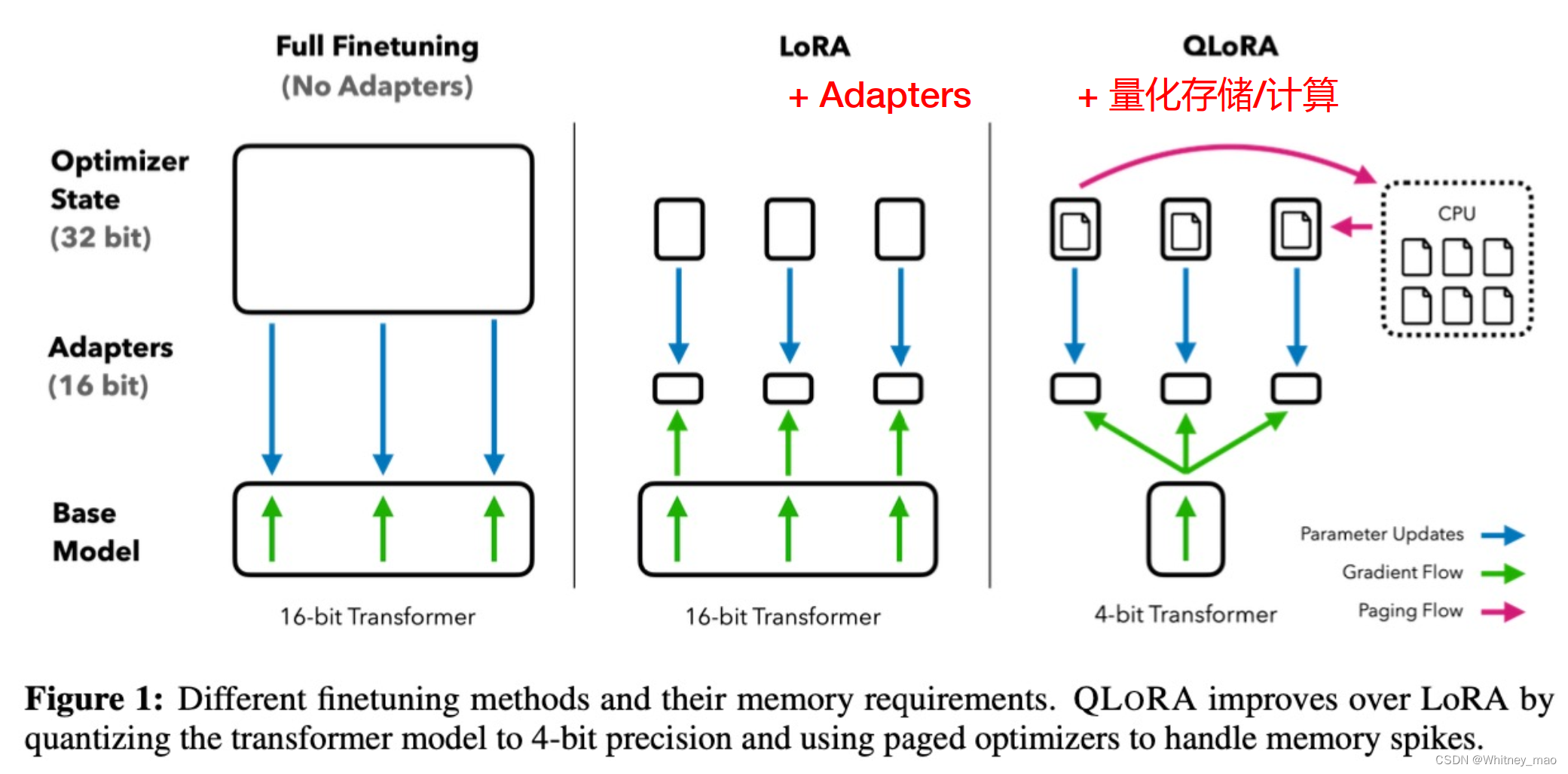

腾讯混元文生图大模型开源训练代码,发布LoRA与ControlNet插件钛媒体App 6月21日消息,腾讯混元文生图大模型(以下简称为混元DiT模型)宣布全面开源训练代码,同时对外开源混元DiT LoRA 小规模数据集训练方案与可控制插件ControlNet。其中,LoRA模型是一种用于微调大型语言模型的技术,在文生图模型中允许用户在不修改原有模型与增加模型大...

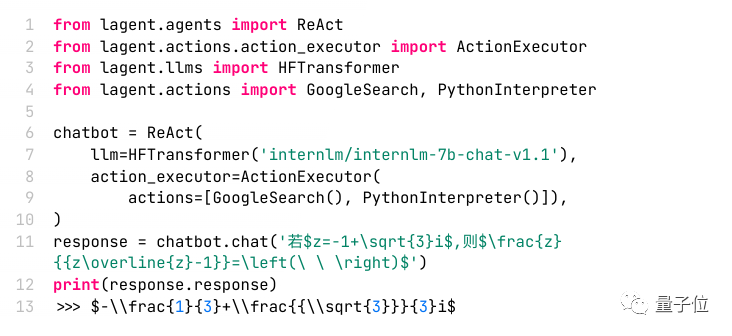

>△< 一行代码提高大模型10%性能,开发者:免费午餐克雷西 发自 凹非寺量子位 | 公众号 QbitAI大模型微调有“免费的午餐”了,只要一行代码就能让性能提升至少10%。在7B参数量的Llama 2上甚至出现了性能翻倍的结果,Mistral也有四分之一的增长。虽然这种方法用在监督微调阶段,但RLHF模型也能从中受益。来自马里兰州大学、纽约...

>△< 四行代码让大模型上下文暴增3倍,羊驼Mistral都适用克雷西 发自 凹非寺量子位 | 公众号 QbitAI无需微调,只要四行代码就能让大模型窗口长度暴增,最高可增加3倍!而且是“即插即用”,理论上可以适配任意大模型,目前已在Mistral和Llama2上试验成功。有了这项技术,大模型(LargeLM)就能摇身一变,成为LongLM。近日,来自得克萨斯农工大...

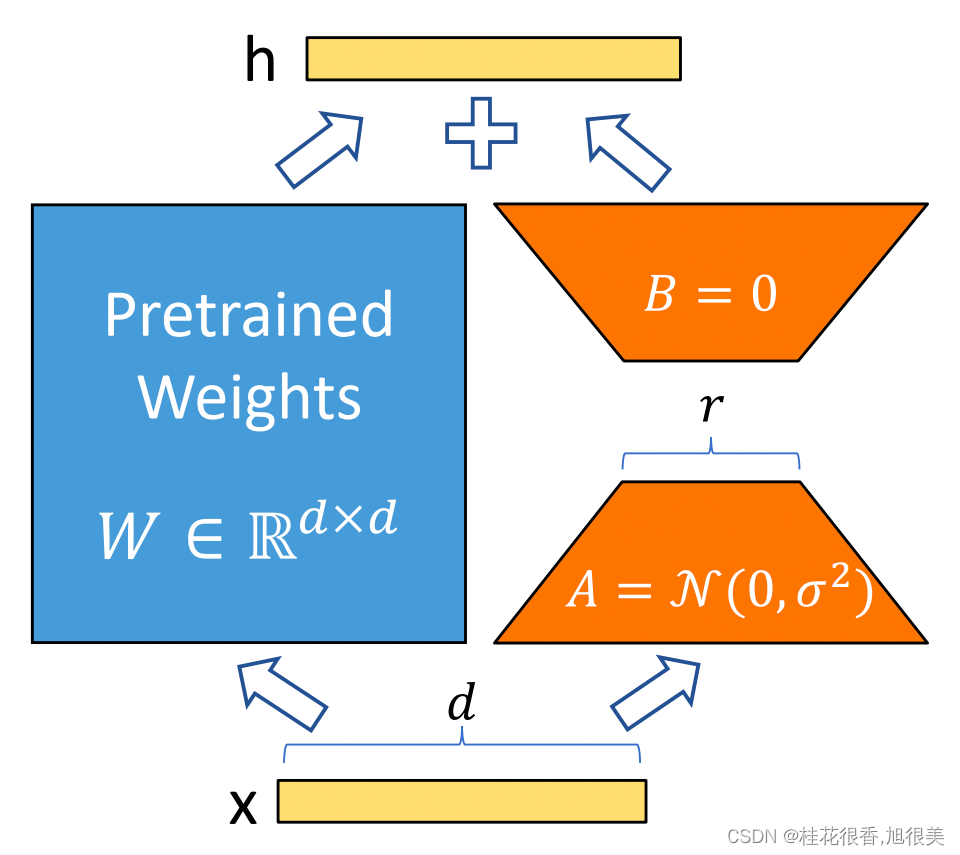

贾佳亚韩松团队新作:两行代码让大模型上下文窗口倍增克雷西 发自 凹非寺量子位 | 公众号 QbitAI只要两行代码+11个小时微调,就能把大模型4k的窗口长度提高到32k。规模上,最长可以扩展到10万token,一口气就能读完一本小说。贾佳亚韩松联合团队提出的这个基于LoRA的全新大模型微调方法,登上了GitHub热榜。这种方式叫做LongLoRA...

ˋ^ˊ

【AI大模型展】网易数帆代码领域大模型——知识增强领域模型加速...网易数帆AI团队共建的网易玉言大模型基座,旨在结合大模型微调和知识增强技术降低实施交付成本,推动AIGC技术落地。玉言大模型曾获中文语言理解权威测评基准 CLUE 分类任务榜单冠军,网易数帆在玉言大模型之上,针对智能软件开发相关需求进行预训练微调,开发了代码领域大模型...

蚂蚁数科面向企业发布大模型服务平台,兼容适配主流开源大模型优化等一站式模型工作台,并实现可视化研发、管理多种具备行业知识库的Agent(智能体)应用,助力企业跑完企业AI应用业务落地的最后一公里。“对企业来说,大模型训练耗时耗力耗资源,AI Max不仅支持主流开源大模型的一键微调训练,还提供三步即完成的零代码模型开发环境,把原先耗...

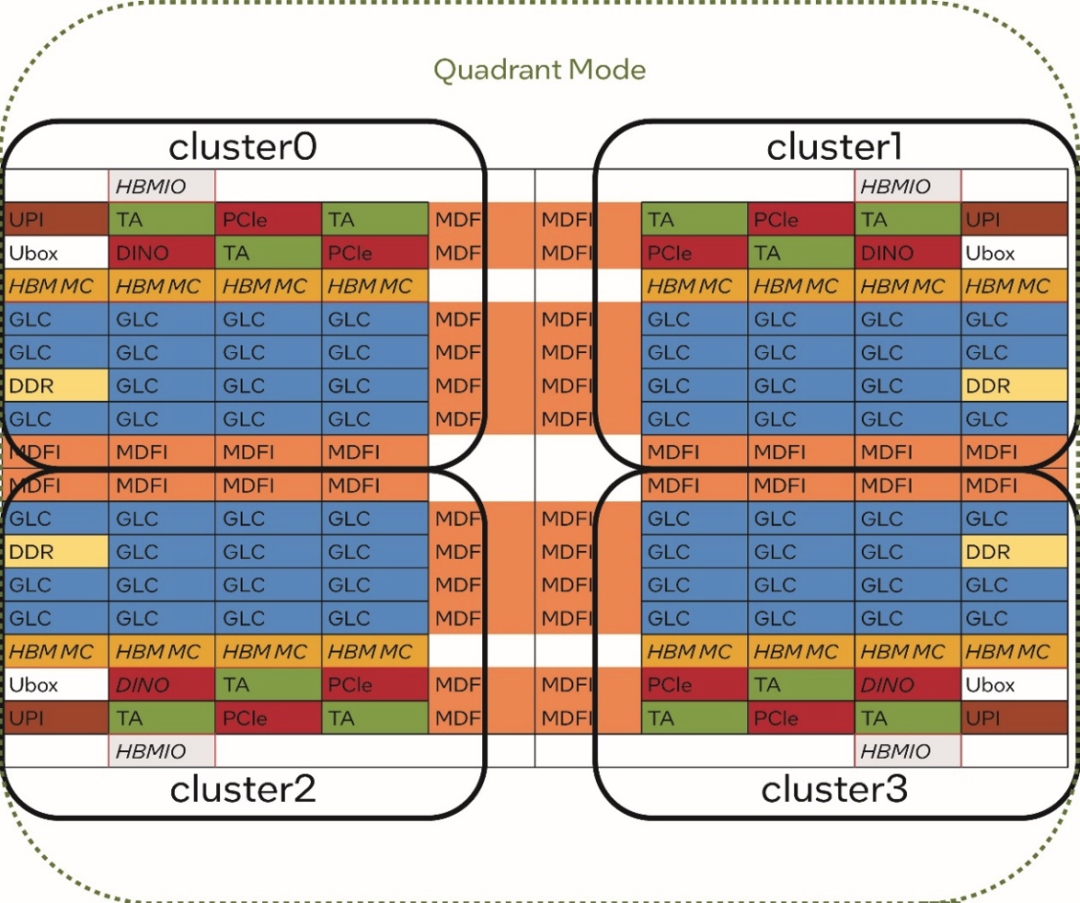

如何优化ChatGLM-6B?一行代码就行 | 最“in”大模型介绍如何通过对其开源 Prompt-tuning 代码进行极少量的修改,并结合第四代英特尔® 至强® 可扩展处理器[1]的全新内置 AI 加速引擎——英特尔® 高级矩阵扩展 (Intel® Advanced Matrix Extension,简称英特尔® AMX)及配套的软件工具,来实现高效、低成本的大模型微调。基于英特尔®...

GPT4单项仅7.1分,揭露大模型写代码三大短板,最新基准测试来了训练以及微调AI模型等。这种 “强到逆天” 的软件开发能力,让一众码农纷纷绝望,直呼:“程序员的末日真来了?”在一众测试成绩中,Devin在S... DevBench首次对大模型进行了从产品需求文档(PRD)到完整项目开发各阶段表现的评测,包括软件设计、依赖环境搭建、代码库级别代码生成...

代码生成模型 Code Llama-34B 已在 HumanEval 测试中击败 GPT品玩8月26日讯,据 phind官方消息,研究团队在Phind 内部数据集上对 CodeLlama-34B 和 CodeLlama-34B-Python 进行微调之后发现,这两款模型微调之后在 HumanEval 测试中的通过率均已超过GPT-4在今年3月份的成绩。Code Llama 是Meta发布的一款代码生成大模型,拥有7B、13B和...

谷歌发布新代码模型Code Gemma:参数小、性能强,硬件要求低!划重点:⭐️ 谷歌发布全新代码模型 Code Gemma,参数小、性能强。⭐️ Code Gemma 共有基础预训练、指令微调和快速推理三个版本。⭐️ Code Gemma 在代码编程、多语言编程等基准测试中表现优异。站长之家(ChinaZ.com) 4月18日 消息:谷歌最近发布了面向企业、开发人员的...

蜂蜜加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com